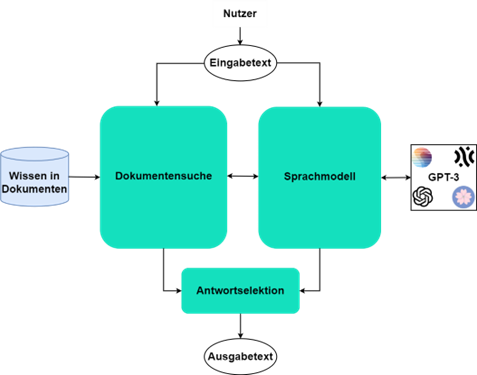

Große vortrainierte KI Sprachmodelle (LLMs) zeigen erstaunliche emergente Fähigkeiten, die sich für eine Vielzahl von industriellen Anwendungen nutzen lassen. Das Weltwissen ist dabei in den Parametern des Modells dargestellt und diese Parameter lassen sich über Fine-Tuning Verfahren für bestimmte Downstream-Tasks optimieren. Alternativ lassen sich die großen KI-Sprachmodellen mit Retriever-based Architekturen kombinieren, um das Domänenwissen von Unternehmen zu berücksichtigen und die Anwendungen effizienter ohne Modifikation des vortrainierten Modelles zu erstellen. Diese sogenannten RAG Methoden werden als weiterer Service im Rahmen von SDIL bereitgestellt und können über ein zukünftiges Mikroprojekt in industriellen Kontexten erprobt werden. Dazu werden die RAG Modelle mit Dokumenten trainiert und über eine geeignete Architektur mit LMMs in Verbindung gebracht. Dieser Ansatz ist auch prinzipiell für multimodale Szenarien geeignet.

Kontakt:

joachim.koehler[at]iais.fraunhofer.de