Hyperparameter Tuning (oder Hyperparameteroptimierung) ist ein wichtiger Schritt im Prozess der Entwicklung und Optimierung künstlicher Intelligenz (KI Modell). Hyperparameter sind die externen Parameter, die das Verhalten des KI-Modells kontrollieren und von den Daten nicht gelernt werden können. Diese Hyperparameter können verändert werden, um die Leistung des Models zu verbessern, aber die Suche nach den optimalen Werten kann zeit- und rechenaufwendig sein.

Stand der Technik

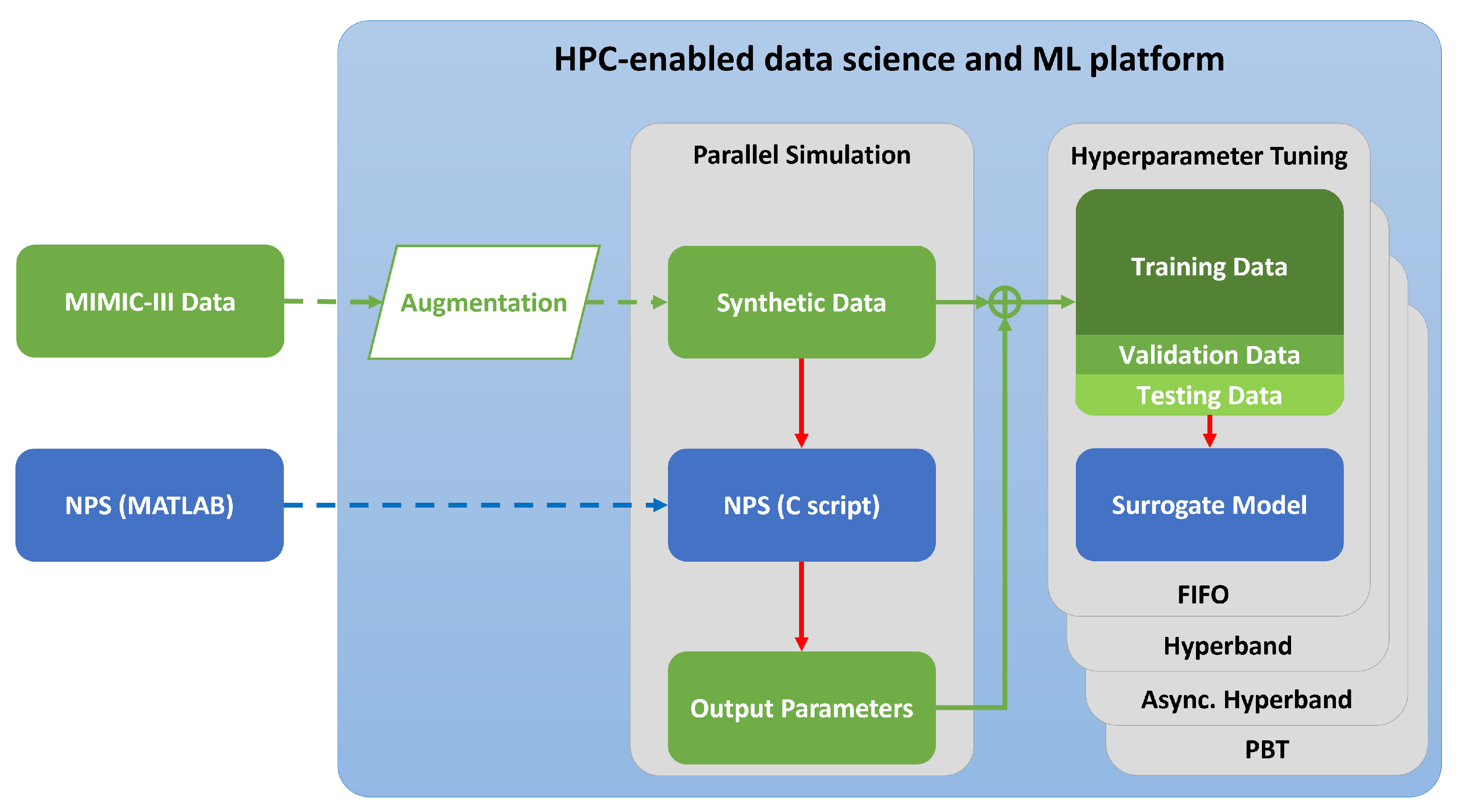

Der Stand der Technik bei der Hyperparameteroptimierung wird ständig verbessert, wobei neue Methoden und Algorithmen entwickelt werden, um die Optimierung durchzuführen und die verfügbare Hardware effizienter und effektiver zu nutzen. In letzter Zeit konzentrierte sich ein Großteil der Forschung auf robuste Algorithmen wie asynchrone sukzessive Halbierung (ASHA) und Bayes’sche Optimierung, die gut skalierbar sind, um die Vorteile paralleler Rechnerarchitekturen zu nutzen.

Technologie

Das Forschungszentrum Jülich hat mit seinen Supercomputern die nötigen Ressourcen und die nötige Erfahrung in der Anwendung, um Hyperparameteroptimierung erfolgreich anzuwenden. Beispielsweise, konnte Hyperparameteroptimierung erfolgreich im SDI-C Mikroprojekt Verbesserung von KI Modellen basierend auf räumlichen Daten in der Agrarwirtschaft angewendet werden.

Vorteile

Mithilfe von Hyperparameter Tuning können sehr viele Hyperparameter Kombinationen erprobt und verglichen werden. Durch die strukturierte Suche werden somit die geeigneten Hyperparameter gefunden, um existierenden Modelle zu optimieren. Mit den Rechenressourcen des Forschungszentrum Jülich stehen die notwendigen Ressourcen hierfür zur Verfügung.