Das KIT optimiert ihre existierenden kleinen und großen neuronalen Netzwerke und passt existierende Architekturen semiautomatisch auf ihre Bedürfnisse an.

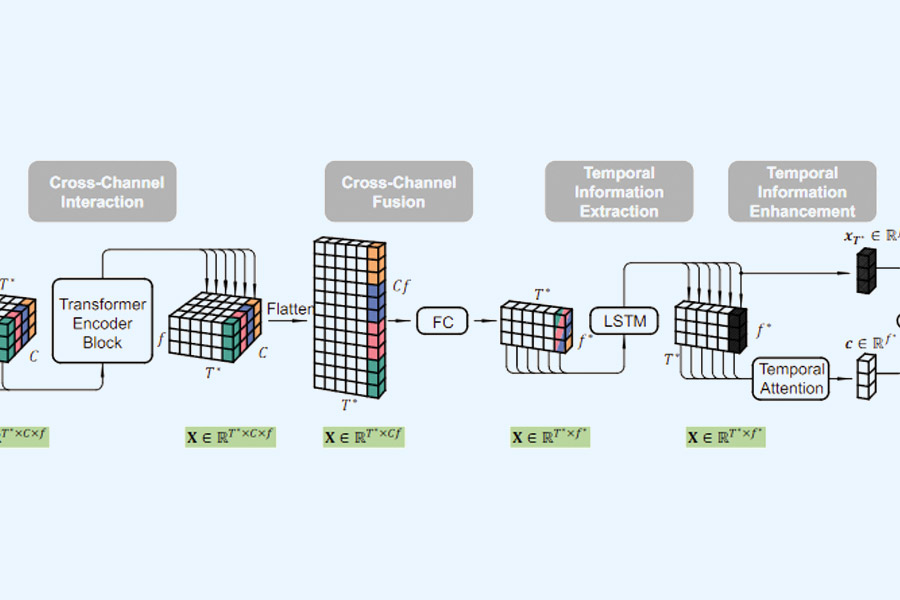

Der Entwurfsraum für Neuronale Netzarchitekturen ist immens. Aktuelle Neuronale-Architekturen können oft durch sehr viele Daten angelernt werden. Aber auch hier fließt viel Erfahrung in die Netzarchitektur ein, damit die Lernalgorithmen konvergieren. Oft ist jedoch sowohl die Datenmenge begrenzt als auch die Rechenkapazität. Hier ist die richtige Wahl der Bausteine noch wichtiger: Erfolgreiche Architekturen zeichnen sich durch geschickt kombinierte Funktionsblöcke aus, die zusätzlich richtig parametrisiert werden müssen.

Neuronale Architektursuchen automatisieren die Wahl eines Netzes innerhalb eines vordefinierten Suchraums. Hierzu werden verschiedenste Strategien eingesetzt. Das KIT hat kann hierzu mehrere Methoden auf Basis von Supernetzwerken, Reinforcement Learning und anderen Blackbox-Optimierungsstrategien in einem Werkzeugkasten anbieten und auf Ihr Problem anwenden.

Insbesondere sind unsere Methoden geeignet, wenn sie das Verhalten ihres neuronalen Netzwerks unter verschiedensten Nebenbedingungen optimieren (Genauigkeit, Ausführungszeit in eingebetteten Systemen, lokales Systemverhalten). In diesen Fällen hilft oft das Lernen mit mehr Daten und mehr Iterationen nur bedingt.

Ein Spezialfall ist außerdem die Optimierung von Funktionsblöcken innerhalb von neuronalen Netzen, so haben wir bereits erfolgreich die Parametrisierung von Filtern und andere Komponenten, welche sich Hardwarenah implementieren lassen, zusammen mit einem neuronalen Netzwerk gelernt.

Erfolgreiche Beispiele für die Anwendung von Architekturoptimierungen: